制作大数据表格需要使用专业的数据分析工具,如Excel、SPSS等。确定数据类型和结构,然后导入数据并设置格式。进行数据分析和可视化展示。

制作大数据是一个复杂的过程,涉及到数据的收集、存储、处理和分析等多个环节,以下是详细的步骤和技术介绍:

数据收集

数据收集是大数据制作的第一步,也是最重要的一步,数据可以来自于各种来源,如社交媒体、网络日志、传感器、机器数据等,数据收集的方法有很多,如爬虫技术、API接口、数据库导入等。

1、爬虫技术:爬虫是一种自动浏览网页并收集信息的程序,它可以模拟人类的行为,访问网页,提取所需的数据。

2、API接口:许多网站和服务都提供了API接口,可以直接获取数据,Twitter的API可以获取用户的推文,Google Maps的API可以获取地理位置信息。

3、数据库导入:如果数据已经存在于数据库中,可以通过SQL语句直接导入。

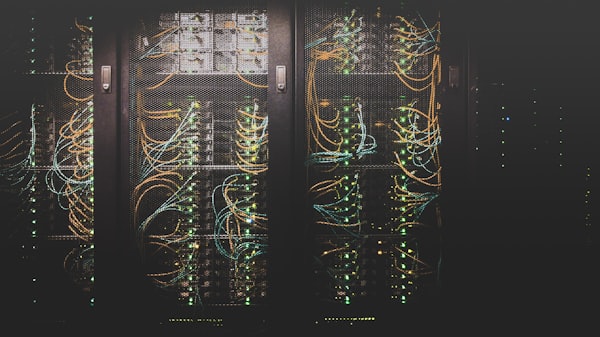

数据存储

数据存储是将收集到的数据保存起来,以便于后续的处理和分析,数据存储的方法有很多,如关系型数据库、非关系型数据库、文件系统等。

1、关系型数据库:关系型数据库是一种基于表的关系模型的数据库,如MySQL、Oracle等,它适合存储结构化的数据。

2、非关系型数据库:非关系型数据库是一种基于键值对或文档的数据库,如MongoDB、Cassandra等,它适合存储半结构化和非结构化的数据。

3、文件系统:文件系统是一种将数据存储在文件中的方法,如HDFS、Amazon S3等,它适合存储大量的原始数据。

数据处理

数据处理是对收集到的数据进行清洗、转换和整合的过程,数据处理的方法有很多,如ETL(Extract, Transform, Load)、MapReduce、Spark等。

1、ETL:ETL是一种从源系统中提取数据,转换数据,然后加载到目标系统的过程,它是数据处理的基本流程。

2、MapReduce:MapReduce是一种分布式数据处理框架,可以在大量服务器上并行处理数据。

3、Spark:Spark是一种快速、通用的大数据处理引擎,支持多种数据处理任务,如批处理、流处理、机器学习等。

数据分析

数据分析是对处理后的数据进行探索和挖掘的过程,目的是发现数据中的模式和趋势,支持决策和创新,数据分析的方法有很多,如统计分析、机器学习、数据可视化等。

1、统计分析:统计分析是一种用数学和统计学方法分析数据的方法,如描述统计、推断统计等。

2、机器学习:机器学习是一种让机器从数据中学习的方法,如分类、回归、聚类等。

3、数据可视化:数据可视化是一种将数据转换为图形或图像的方法,如柱状图、折线图、散点图等。

相关问题与解答

1、问题:如何处理实时产生的大数据?

解答:可以使用流处理技术,如Apache Storm、Apache Flink等,这些技术可以在数据产生时立即进行处理,而不是等待所有数据都收集完毕后再处理。

2、问题:如何处理非结构化的大数据?

解答:可以使用非关系型数据库或文件系统来存储非结构化的数据,还可以使用文本分析和自然语言处理技术来处理非结构化的数据。

3、问题:如何保证大数据的安全性?

解答:可以使用加密技术来保护数据的隐私,使用访问控制技术来限制数据的访问权限,使用备份和恢复技术来防止数据丢失。

4、问题:如

评论留言